PRESS RELEASE (技術)

2016年9月21日

株式会社富士通研究所

GPUのメモリ効率化技術により

Deep Learningのニューラルネット規模を約2倍に拡大

株式会社富士通研究所(注1)(以下、富士通研究所)は、学習の高精度化に向けたニューラルネットの大規模化に対応するため、GPUの内部メモリの利用効率を向上させる技術を開発し、最大で従来比約2倍規模のニューラルネットの学習を可能にしました。

大量の演算が必要なDeep Learningの学習処理において、近年、GPUを用いて高速に学習を行う技術が注目されています。GPUの高速な演算性能を活用するためには、一連の演算に使用するデータをGPUの内部メモリに格納する必要がありますが、メモリ容量によって学習可能なニューラルネットの規模が制限されるという課題がありました。

今回、学習の開始時にニューラルネットの構造を解析して、メモリ領域を効率的に再利用できるように演算順序とデータのメモリへの配置を最適化するメモリ効率化技術を開発し、オープンソースソフトウェアのDeep Learningフレームワーク「Caffe」に実装して評価しました。広く研究の領域で使用されている画像認識用ニューラルネット「AlexNet」や「VGGNet」(注2)において、GPUの内部メモリ使用量を40%以上削減できるなど、最大で約2倍規模のニューラルネットの学習が可能となることを確認しました。

本技術により、GPU1台で高速に学習できるニューラルネットの規模を拡大でき、より高精度なモデルの開発が可能となります。富士通研究所では、本技術を、富士通株式会社のAI技術「Human Centric AI Zinrai(ジンライ)」の一つとして実用化を目指し、お客様とともにAIの活用に取り組んでいく予定です。

本技術の詳細は、9月13日(火曜日)から16日(金曜日)までイタリアのサレルノで開催された国際会議「MLSP(IEEE Machine Learning for Signal Processing 2016)」にて発表しました。

開発の背景

近年、人間の脳の仕組みを模擬したDeep Learningと呼ばれる機械学習手法が注目を集めています。Deep Learningは、ニューラルネットの層数が多いほど認識や分類などの精度の向上が図れることから高精度化のため大規模化が進んでいますが、それに合わせて学習時間が増大していくため、大量データの計算が得意なGPUの活用やスーパーコンピュータのように複数のGPUを並列動作させて高速化する技術が注目されています。

課題

Deep Learningの大規模化の手法として、一つのニューラルネットを複数のコンピュータに分割して計算を進めるモデル並列の手法がありますが、複数のコンピュータ間でやり取りをする際の転送データ量がボトルネックとなり学習の速度が大幅に低下します。GPUの高速な演算性能を活用するためには、一連の演算に使用するデータを可能な限りGPUの内部メモリに格納する必要がありますが、GPUは搭載しているメモリの量が一般的なコンピュータより小さいため、高速に学習できるニューラルネットの規模が制限されるという課題がありました。

開発した技術

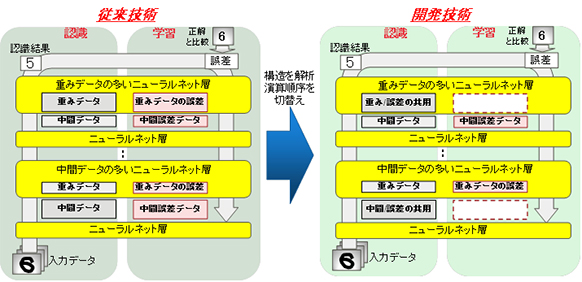

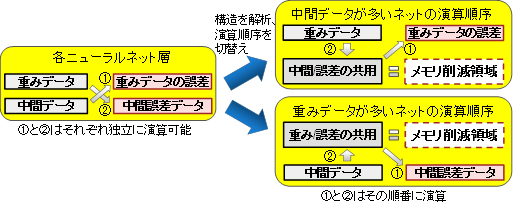

今回、大幅に学習速度が低下してしまうモデル並列の手法を使わずに、1台のGPUで計算できるニューラルネットの規模を拡大できるメモリ効率化技術を開発しました。ニューラルネットの各層での学習処理において、重みデータから中間誤差データを求める演算と、中間データから重みデータの誤差を求める演算を独立に実行できることに着目して、学習の開始時に、ニューラルネットの各層の構造を解析し、より大きなデータを配置しているメモリ領域を再利用できるように演算の処理順序を切り替えることにより、メモリ使用量を削減します。

図1 メモリ効率化技術

効果

今回開発した技術を、オープンソースソフトウェアのDeep Learningフレームワーク「Caffe」に実装しGPUの内部メモリ使用量を計測しました。研究分野で広く使用されている画像認識用ニューラルネット「AlexNet」や「VGGNet」を用いた評価では、本技術適用前と比較し40%以上のメモリ使用量削減を達成するなど、GPU1台あたり最大で約2倍の規模のニューラルネットを学習することが可能になります。

これにより、複雑な処理が求められる大規模なニューラルネットでもGPUの性能を生かした高速な学習演算が可能となり、より高精度なモデルの開発が加速します。

今後

富士通研究所では、今回開発した技術を富士通株式会社のAI技術「Human Centric AI Zinrai(ジンライ)」の一つとして、2016年度末までの実用化を目指します。また、すでに発表しているGPUの並列化によるDeep Learning学習処理の高速化技術(注3)と組み合わせて、技術の改善を行っていきます。

商標について

記載されている製品名などの固有名詞は、各社の商標または登録商標です。

以上

注釈

- 注1 株式会社富士通研究所:

- 本社 神奈川県川崎市、代表取締役社長 佐々木繁。

- 注2 「AlexNet」や「VGGNet」:

- 画像認識を行う多層のニューラルネット。AlexNetは2012年の画像分類コンテスト、VGGNetは2014年の位置検出コンテストでそれぞれ世界最高認識精度を達成し、現在の画像認識ニューラルネットのベースとなっている。

- 注3 GPUの並列化によるDeep Learning学習処理の高速化技術:

- 「Deep Learning学習処理の高速化技術を開発」(2016年8月9日プレスリリース)

本件に関するお問い合わせ

株式会社富士通研究所

コンピュータシステム研究所

![]() 044-754-2931 (直通)

044-754-2931 (直通)

![]() ngcs_ai_press_mem@ml.labs.fujitsu.com

ngcs_ai_press_mem@ml.labs.fujitsu.com

プレスリリースに記載された製品の価格、仕様、サービス内容、お問い合わせ先などは、発表日現在のものです。その後予告なしに変更されることがあります。あらかじめご了承ください。